Боты: на заре интернета и сегодня

Сегодня боты ассоциируются с телеграмом и другими современными инструментами, но мало кто знает, что некоторые пользователи сталкивались с ними еще во времена СССР. Наталья Конрадова рассказывает, как развивались боты, могут ли они обмануть человека и стоит ли их бояться.

Как все начиналось

Во времена праинтернета, когда по нему еще нельзя было бродить, а можно было только cкачивать и закачивать файлы, самым популярным местом для дискуссий была сеть Юзнет. В России ее называли «конференциями», а по сути это были почтовые тематические рассылки. Имея доступ к интернету, можно было подписаться на интересующую тебя тему: от проблем родительства или перспектив феминизма до научной фантастики, не говоря уже о софте и харде. Пользователь не только получал все сообщения от других подписчиков группы, но и мог ответить им. Очень похоже на современный сервис Google Groups, который, кстати, лет десять назад купил и опубликовал почти весь архив Юзнета.

Так вот, в конце 1980-х в Юзнете появилась группа talk.politics.soviet, посвященная политике СССР. Она стала особенно популярной после того, как к Юзнету в 1989 году присоединились советские пользователи, и была активной вплоть до 1995-96-х годов. Когда все перешли на html-протокол, Юзнет был поглощен вебом. Появилось то, что сегодня называется интернетом.

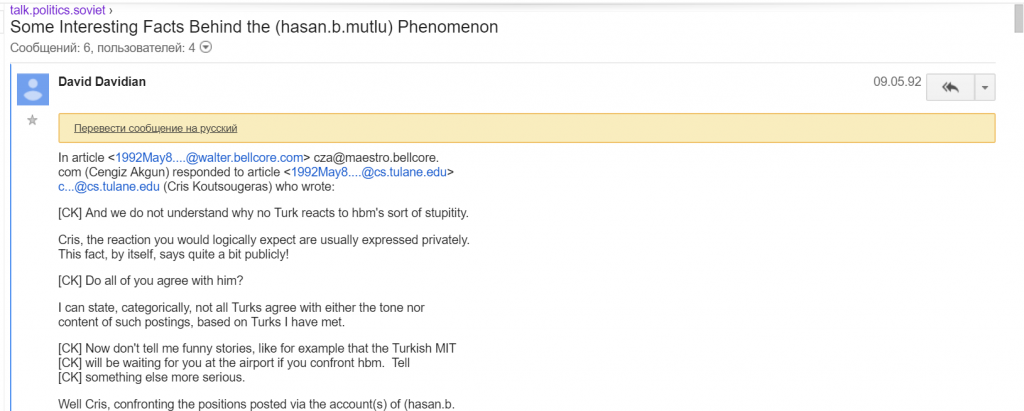

В начале 1990-х годов в этой группе было много русскоязычных пользователей, но основным языком переписки оставался английский. В какой-то момент там появился подписчик по имени Хасан Мутлу. Он бесконечно писал огромные послания, в которых обвинял армян в геноциде азербайджанцев и турок. Тема группы была связана с уже несуществующим Советским Союзом и его политикой, которую после распада СССР обсуждали очень активно. Одним из болезненных вопросов была национальная политика, в частности, конфликт между армянами и азербайджанцами. В первое время Мутлу нашел своего верного читателя, Давида Давидяна, который честно отвечал на нападки и обвинения в адрес армян, оперируя фактами и пытаясь вести диалог. На каждый ответ Мутлу снова засылал тысячи знаков с цитатами и фактами. Они часто не имели ничего общего с предыдущим высказыванием, зато всегда вызывали негодование, и не только у армян. Короче говоря, Мутлу вел себя как обычный флеймер, только слишком активный и предельно неадекватный.

Чтобы понять, что Мутлу — не живой человек, а хорошо сделанный бот, подписчикам пришлось дождаться Дня Благодарения. Обсуждение традиционного блюда — индейки — неожиданно для всех спровоцировало Мутлу на очередную серию постов об армянах. Все потому, что искусственный интеллект Мутлу не смог отличить слова Turkey (Турция) и turkey (индейка). С тех пор, как пользователи сделали это открытие, их главной задачей стало не упоминать ни Мутлу, ни Турцию, ни индейку, чтобы не вызывать новых потоков хейт-спича (а поскольку обсудить достижения AI все же хотелось, Мутлу на время заменили на Мудлу).

Могут ли современные боты обмануть человека

Сегодняшние боты — не чета Мутлу. Они не только умело отличают заглавные и прописные, но и один за другим проходят тест Тьюринга. Но боты — это лишь фасад большой проблемы, которую уже много лет решают представители разных наук. Проблемы «мыслящей машины», как ее называл сам Тьюринг. Вопрос уже давно не в том, умеют ли машины мыслить, а в том, могут ли они обмануть человека. Человек, который вдруг обнаруживает, что разговаривает с ботом, а не с себе подобным, впадает во фрустрацию, подобную uncanny valley — чувству, которое испытывает человек, если видит робота, слишком похожего на другого человека.

Боты сегодня — такая же реальность, как телефоны в 1970 году, когда японский робототехник Масахиро Мори открыл эффект uncanny valley. Конечно, приятнее общаться с живым человеком, а не с программой. Но если это, например, фейсбук, то на всех пользователей сотрудников не хватит. Вопрос в том, хотят ли боты обмануть человека, сделав вид, что они тоже люди.

Прохождение программами теста Тьюринга рассматривается профессионалами как путь к улучшению искусственного интеллекта, который все больше и больше учитывает нюансы интеллекта естественного. У человечества уже есть Siri и Алиса, а также роботизированные секс-куклы. В прошлом году российская разработка прошла 33% ответов теста — это, согласно Тьюрингу, признак мыслящей машины. То есть той, которой удалось обмануть человека-судью.

Хотя тест Тьюринга подвергается критике, он постоянно развивается. Например, одна из разновидностей теста — схема Винограда, в которой учитывается не только языковая логика, но и нюансы естественного языка. Точнее, один и тот же нюанс: неоднозначность местоимения в зависимости от контекста. Возьмем, к примеру, утверждение: «Пожарные прибыли после/до полиции, потому что они ехали издалека». Ответ на вопрос, кто именно прибыл издалека, зависит от слов «после/до». Если «до», то издалека прибыли полицейские. Если «после», то пожарные. Эта та часть языковой логики, которая пока недоступна ботам — точно так же, как заглавные и прописные были недоступны Мутлу в 1992 году.

Опасения экспертов

Пару лет назад с проблемой языка столкнулся и фейсбук. Запустив умных ботов, способных учиться в процессе разговора с человеком, руководство социальной сети вдруг обнаружило, что те начали поощрять сами себя, и в итоге разработали собственный язык, непонятный человеку. И если доверие Цукерберга к искусственному интеллекту не было подорвано этим казусом, то Илон Маск, а также Стивен Хокинг высказались категорически против роботов и AI. «Я продолжаю бить тревогу, — говорит Маск, — но пока люди сами не увидят роботов, которые ходят по улицам и убивают людей, они не узнают, как реагировать на искусственный интеллект». Стивен Хокинг был еще более категоричен: «Появление полноценного искусственного интеллекта может стать концом человеческой расы». Все это — комментарии профессионалов, которые действительно верили и верят в возможность появления мыслящей машины.

Но кажется, настоящая опасность исходит не от искусственного интеллекта, а от настоящих людей. Тех, которые работают на выборах в разных странах, имитируют политическую позицию, постят мнения, пришедшие по разнарядке от заказчика, и заводят бесчисленные аккаунты, в которых трудно распознать фейковую личность. Как и в случае с чат-ботами, которые легко обманывают людей, социальные боты доказывают только то, что человека в принципе обмануть несложно.