Война нейросетей: как одни ИИ создают фейковые видео, а другие их разоблачают

В середине июня в сети появилось видео, на котором Марк Цукерберг рассуждает, как классно обладать данными миллиардов человек. Ролик ненастоящий — его создали с помощью нейросетей, но движения и мимика основателя Facebook настолько реалистичны, что многие поверили дипфейку. Как и нескольким другим подобным записям ранее. Однако исследователи изобрели технологию, способную распознать фейковый контент. Screenlifer рассказывает, как одни разработчики создают дипфейки, а другие придумывают для них антидоты.

7 июня художники Билл Постерс и Дэниел Хоу совместно с рекламным агентством Canny выложили в инстаграм видео с Марком Цукербергом в главной роли. Создатель Facebook рассказал зрителям о контроле данных миллиардов человек и заявил, что «тот, кто владеет информацией — владеет будущим».

Как бы ни хотелось пользователям вновь начать ругать Цукерберга за столь фривольное обращение с их данными, в этом случае повода для критики нет. Потому что ролик смонтировали с помощью искусственного интеллекта Canny, который может заменять диалоги в видео (VDR или video dialogue replacement).

В оригинальной записи 2017 года Марк рассуждает о российском вмешательстве в американские выборы. Нейросети потребовалось проанализировать всего 21 секунду ролика, чтобы создать фейковый вариант. А если еще вспомнить, что недавно разработчики из «Сколково» научили ИИ генерировать фальшивые видео всего по одной фотографии, можно только поразиться тому, как легко искусственному интеллекту дается создание дипфейков.

Цукерберг — не единственное творение Постерса и Хоу. В том же июне они выложили видео с Ким Кардашьян, где она благодарит хейтеров за свою сумасшедшую популярность. Основой этой записи стало интервью селебрити для Vogue в апреле 2019 года.

Фейковые видео — это искусство

Оба видео — это своеобразное промо для выставки Spectre, которую организовали Билл Постерс и Дэниел Хоу в Великобритании. По словам художников, на ивенте они хотели «раскрыть секреты цифрового влияния» и посвятили инсталляцию таким вопросам, как приватность, свобода воли и пропаганда. Событие прошло в рамках Международного фестиваля документального кино в Шеффилде с 6 по 11 июня.

Билл Постерс считает, что фейковые видео — это тоже искусство. В комментарии VICE художник заявил, что привлечение внимания к проблеме — один из шагов на пути к ее решению.

«Мы пытаемся обратить на это внимание. Как мы можем серьезно бороться и обсуждать эти бесконечно важные вопросы, если нам даже не позволено использовать искусство для критического представления технических гигантов?»

Профессор права университета Мэриленда Даниэль Ситрон согласна с художником и считает, что дипфейки не всегда несут вред.

«Порой дипфейки вносят вклад в искусство — например, в “Звездные войны” вернулась Кэрри Фишер. Многое зависит от контекста, и мы не можем чесать все искусственные видео под одну гребенку».

Возможно, с этими доводами частично согласно и руководство соцсетей. Ведь Facebook не стал удалять ролики, а всего лишь занизил их приоритет в выдаче и поставил пометку о том, что контент сгенерирован ИИ. А сам Цукерберг заявил, что к подобным видео необходимо относиться иначе, чем к фейковым новостям, пишет Business Insider.

Создатель Facebook считает, что на данном этапе развития нейросетей важно действовать осторожно и не реагировать на такие ролики, как на традиционную дезинформацию. Правда, никакой конкретики от Марка пока не поступило.

Как распознавать фейковые видео

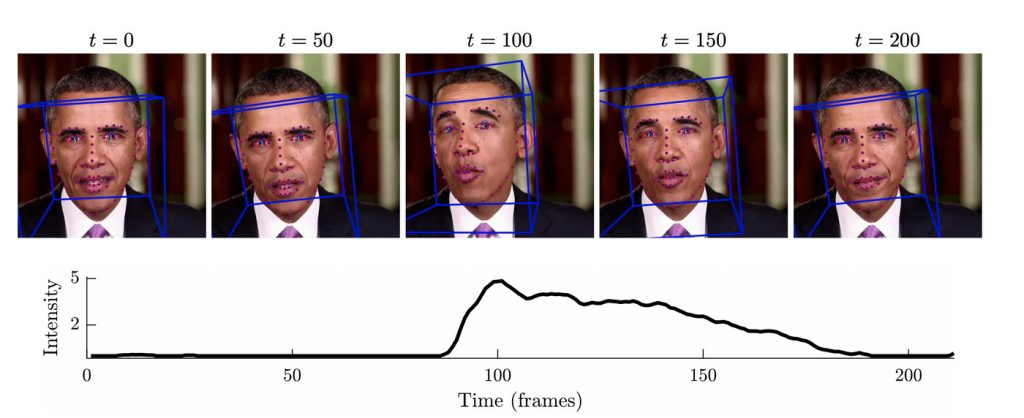

Зато вариант решения появился у исследователей из Калифорнийского и Южно-Калифорнийского университетов. Они представили новую технологию, которая умеет распознавать дипфейки, основываясь на индивидуальных жестах и манере речи человека, пишет Technology Review. Разработчики натренировали нейросеть отличать уникальные микродвижения. К примеру, дипфейки пока не в состоянии воссоздать то, как Трамп пожимает плечами, а также зачастую ошибаются с морганием — на сгенерированных ИИ видео люди порой вообще не смыкают глаз, а иногда наоборот — выглядят так, будто у них нервный тик.

Исследователи верят, что их изобретение поможет политикам и знаменитостям не «появляться» в дипфейках. Точность распознавания фальшивых видео составила 92% — это довольно неплохой показатель. Однако даже создатели не уверены, что эффект будет долгоиграющим. Как показывает практика, искусственные интеллекты, генерирующие поддельные ролики, адаптируются к антидотам так же быстро, как вирусы — к вакцинам.

Профессор Южно-Калифорнийского университета Хао Ли вообще считает, что в диджитал-эру мы — зрители своеобразного соревнования.

«Мы становимся свидетелями гонки между цифровыми манипуляторами и способностью их распознать. А технологическое развитие алгоритмов искусственного интеллекта — катализатор обеих сторон».

Именно по этой причине авторы нового антидота дипфейков пока не раскрывают коды, на которых работает нейросеть. Однако невозможно предсказать, насколько долго это будет препятствием для искусственного интеллекта. Так что пока вся надежда лишь на сознательность и внимательность пользователей.